Meta新模型要来了,但Llama 4的锅谁来接?1300多位作者的联合报告来了

Meta新模型要来了,但Llama 4的锅谁来接?1300多位作者的联合报告来了路透社最新消息,Meta 新成立的 AI 团队本月已在内部交付了首批关键模型。据悉,该消息来自 Meta 公司的 CTO Andrew Bosworth,他表示该团队的 AI 模型「非常好」(very good)。

路透社最新消息,Meta 新成立的 AI 团队本月已在内部交付了首批关键模型。据悉,该消息来自 Meta 公司的 CTO Andrew Bosworth,他表示该团队的 AI 模型「非常好」(very good)。

从救火Llama 4反被裁,再到如今下场自创业,AI大佬田渊栋回顾了2025年一些重要时刻。

图灵奖大佬LeCun离职Meta后直接开怼:实锤Llama4造假传闻,炮轰原上司Alexandr Wang「不懂科研」,称Meta冲刺「超级智能」完全是被大模型洗脑。同时,他也透露自己的新公司即将在今年发布全新世界模型。

本该绽放的Llama 4黯然失色,Meta内部地震频发:首席AI科学家离职、600人裁员、顶级大佬空降、开源战略转向。最新模型Avocado被曝延期且套壳Qwen,扎克伯格如何在对手狂飙中绝地反击?

Llama4性能造假丑闻,OpenAI烧钱的速度远超过了盈利能力;另外一方面:国产模型凭借足够强大的性能与超高性价比,迅速占领了国际开源模型市场。是时候再次为国产AI鼓掌了!

出品 / 新浪科技(ID:techsina) 作者 / 郑峻 Meta AI业务大地震!新主管上任三个月后,挥起裁员大刀,基础研究部门遭受重创,连明星大牛研究员都不幸失业。扎克伯格这是急功近利,自毁长

刚刚从Meta一线获悉,田渊栋前脚刚发了推文说自己被裁,后脚就被解除了公司内部各种权限——嘿,亚历山大王的刀,就是这么快。这也是这次裁员中最具争议的地方,“在Meta工作已超过十年的田渊栋和他的组员,整组被一锅端了”,这是为什么?

从Llama 4「作弊刷分」丑闻,到143亿美元收购Scale AI,扎克伯格疯狂挖角,却换来团队内讧;上亿美元年薪,没能留住顶尖人才。Meta的超级智能实验室(MSL),到底是未来引擎,还是人心崩盘的深坑?

Meta在半年内第四次重组AI部门,将超级智能实验室拆分为四个团队,全面押注「超级智能」。新成立的TBD Lab由Alexandr Wang领衔,或放弃Llama 4并转向闭源模型,Meta开源旗帜动摇。Meta内部人心浮动,几家欢喜几家愁。

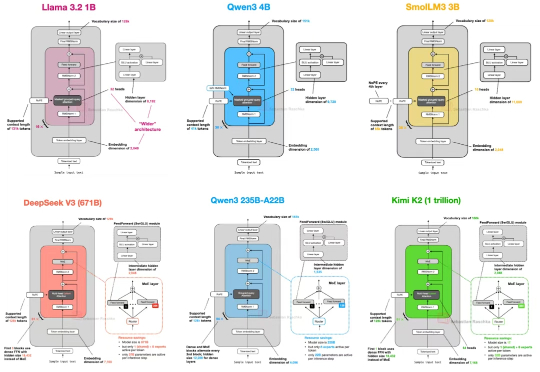

自首次提出 GPT 架构以来,转眼已经过去了七年。 如果从 2019 年的 GPT-2 出发,回顾至 2024–2025 年的 DeepSeek-V3 和 LLaMA 4,不难发现一个有趣的现象:尽管模型能力不断提升,但其整体架构在这七年中保持了高度一致。